[비즈니스포스트] 고대역폭메모리(HBM) 수요는 늘고 있는 반면 기술 난도가 높아지고 D램 탑재량이 증가하고 있어 인공지능(AI) 반도체 공급 병목현상이 지속될 것으로 분석되고 있다.

대만 매체 커머셜타임스는 20일 “글로벌 4대 클라우드 서비스 제공업체(CSP)인 아마존, 마이크로소포트, 구글, 메타는 인공지능(AI) 인프라를 확장하고 있으며, 이와 관련한 올해 자본 지출은 1700억 달러(약 230조 원)에 이를 것”이라고 전망했다.

![HBM 적층 난도 높아져 공급 부족, AI반도체 공급 병목현상 장기화하나]()

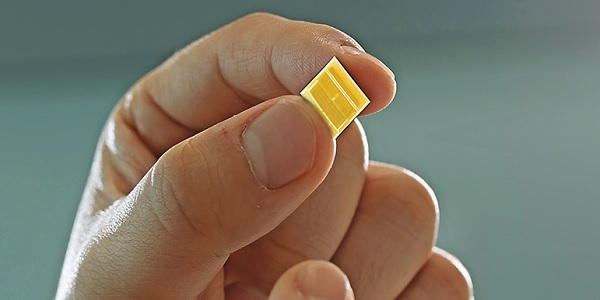

| ▲ SK하이닉스의 HBM 'D램 탑재량'과 공정 난이도가 동시에 상승하면서 AI칩 병목현상이 단기간에 해소되기 어려울 것이란 전망이 나왔다. SK하이닉스의 HBM3 메모리 홍보용 사진. < SK하이닉스 > |

AI 반도체인 그래픽처리장치(GPU) 세계 수요의 약 80%는 엔비디아가 담당한다.

엔비디아가 설계한 GPU는 TSMC의 '칩 온 웨이퍼 온 서브스트레이트(CoWoS)' 패키징을 통해 완성된다. TSMC는 2024년 말 CoWoS 생산 능력이 월간 약 4만 개(웨이퍼)까지 증가하고, 2025년에는 8만 개까지 늘어날 것으로 전망된다.

하지만 엔비디아가 새롭게 출시한 고성능 AI 반도체인 B100, B200은 사용하는 인터포저(미세회로기판) 면적이 이전보다 커져, 같은 12인치 웨이퍼에서 생산할 수 있는 반도체가 줄어드는 것으로 전해졌다.

따라서 급증하는 GPU 수요를 패키징이 따라가지 못하는 병목현상이 지속될 것으로 분석됐다.

HBM 공급 부족도 AI 반도체 공급 병목현상의 원인으로 꼽힌다.

현재 HBM에서 시장점유율 1위를 차지하고 있는 SK하이닉스는 HBM 1알파 생산 단계에서는 레이어 하나에서만 극자외선(EUV) 노광장비를 활용했던 것으로 파악된다.

하지만 올해부터는 1베타로 전환해 EUV를 활용하는 레이어를 3~4개로 늘릴 것으로 전망되고 있다. 경쟁사인 삼성전자는 이미 5개의 레이어에 EUV 공정을 적용하고 있다.

HBM 내 D램 적층이 계속 증가하고 있는 점도 HBM 공급이 충분하지 않은 원인으로 지목된다.

HBM2의 D램 적층 수는 4~8개였는데, HBM3/3E에서는 8~12개로 증가했다. HBM4의 D램 적층 수는 16개까지 늘어날 것으로 예상된다.

커머셜타임스는 “이와 같은 AI 반도체 공급의 이중 병목현상은 여전히 단기적으로 극복하기 어려울 것”이라며 “인텔은 12인치 웨이퍼를 대체하기 위해 유리 반도체 기판을 연구하고 있지만 시간이 필요하다”고 분석했다. 나병현 기자